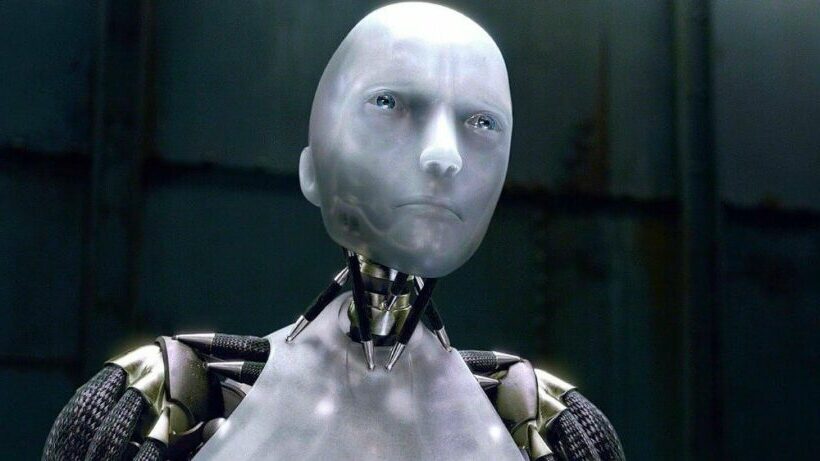

Если робот в сознании, можно ли его выключить?

В эпизоде «Звездный путь: Следующее поколение» «Мера человека» Дейта, андроид, член экипажа «Энтерпрайза», должен быть демонтирован для исследовательских целей, если только капитан Пикард не сможет утверждать, что Дейта заслуживает тех же прав, что и человек. существование. Естественно возникает вопрос: на каком основании что-то имеет права? Что дает сущности моральное положение?

Философ Питер Сингер утверждает, что существа, способные чувствовать боль или страдать, имеют право на моральное положение. Он утверждает, что нечеловеческие животные имеют моральное положение, поскольку они могут чувствовать боль и страдать. Ограничение его людьми было бы формой спесишизма, чем-то вроде расизма и сексизма.

Не одобряя ход рассуждений Сингера, мы могли бы задаться вопросом, можно ли его распространить на робота-андроида, такого как Дейта. Это потребует, чтобы Дейта мог либо чувствовать боль, либо страдать. И то, как вы на это ответите, зависит от того, как вы понимаете сознание и интеллект.

По мере того, как реальные технологии искусственного интеллекта приближаются к голливудским воображаемым версиям, вопрос морального положения становится все более важным. Если у ИИ есть моральные принципы, рассуждают такие философы, как я, из этого может следовать, что они имеют право на жизнь. Это означает, что вы не можете просто демонтировать их, а также может означать, что люди не должны вмешиваться в достижение ими своих целей.

Два вкуса интеллекта и тест

Шахматная машина IBM Deep Blue была успешно обучена побеждать гроссмейстера Гэри Каспарова. Но ничего другого он сделать не мог. У этого компьютера было то, что называется предметно-ориентированным интеллектом.

С другой стороны, есть такой тип интеллекта, который позволяет хорошо делать множество вещей. Это называется общим интеллектом предметной области. Это то, что позволяет людям готовить, кататься на лыжах и воспитывать детей — задачи, которые связаны между собой, но в то же время очень разные.

Искусственный общий интеллект, AGI, — это термин для машин, обладающих общим интеллектом предметной области. Возможно, ни одна машина еще не продемонстрировала такой интеллект.

Этим летом стартап OPENAI выпустил новую версию своей языковой модели Generative Pre-Training. GPT-3 — это система обработки естественного языка, обученная чтению и письму, чтобы ее могли легко понять люди.

Он сразу же привлек внимание не только из-за своей впечатляющей способности имитировать стилистические изгибы и составлять правдоподобный контент, но и из-за того, насколько далеко он ушел от предыдущей версии. Несмотря на эту впечатляющую производительность, GPT-3 на самом деле не знает ничего, кроме того, как связывать слова различными способами. До AGI еще далеко.

Названный в честь первопроходца-исследователя ИИ Алана Тьюринга, тест Тьюринга помогает определить, является ли ИИ разумным. Может ли человек, разговаривающий со скрытым ИИ, сказать, ИИ это или человек? Если он не может, то для всех практических целей ИИ умен. Но этот тест ничего не говорит о том, может ли ИИ быть в сознании.

Два вида сознания

Сознание состоит из двух частей. Во-первых, это аспект опыта «как это для меня», сенсорная часть сознания. Философы называют это феноменальным сознанием. Речь идет о том, как вы испытываете явление, например, чувствуете запах розы или чувствуете боль.

Напротив, есть еще доступ к сознанию. Это способность сообщать, рассуждать, вести себя и действовать скоординировано и реагировать на стимулы, основанные на целях.

Например, когда я передаю футбольный мяч своему другу, который играет в ворота, я реагирую на визуальные стимулы, действуя в соответствии с предыдущей тренировкой и преследуя цель, определенную правилами игры. Я делаю пас автоматически, без обдумывания, по ходу игры.

Слепое зрение прекрасно иллюстрирует разницу между двумя типами сознания. Кто-то с этим неврологическим заболеванием может сообщить, например, что он ничего не видит в левой части своего поля зрения.

Но если попросить взять ручку из набора объектов в левой части их поля зрения, они уверенно это сделают. Они не могут видеть ручку, но могут взять ее, когда их попросят — пример доступа к сознанию без феноменального сознания.

Данные — это андроид. Как эти различия проявляются по отношению к нему?

Дилемма данных

Данные андроида демонстрируют, что он обладает самосознанием, поскольку он может контролировать, например, оптимально ли он заряжен или есть ли внутренние повреждения его роботизированной руки.

Данные также разумны в общем смысле. Он делает много различных вещей на высоком уровне мастерства. Он может управлять «Энтерпрайзом», выполнять приказы капитана Пикарда и обсуждать с ним лучший путь.

Также он может играть в покер со своими товарищами по кораблю, готовить, обсуждать наболевшие вопросы с близкими друзьями, сражаться с врагами на чужих планетах и заниматься различными видами физического труда. Данные имеют доступ к сознанию. Он явно прошел бы тест Тьюринга.

Однако Дейта, скорее всего, не обладает феноменальным сознанием — он, например, не наслаждается ароматом роз и не испытывает боли. Он воплощает в себе увеличенную версию слепого зрения. Он осознает себя и имеет доступ к сознанию — может взять ручку — но во всех своих чувствах ему не хватает феноменального сознания.

Теперь, если Дейта не чувствует боли, по крайней мере одна из причин, предложенных Сингером для придания существу морального статуса, не выполняется. Но Дейта может соответствовать другому условию способности страдать, даже не чувствуя боли. Страдание может не требовать феноменального сознания, в отличие от боли.

Например, что, если бы страдание также определялось как лишение возможности преследовать справедливое дело без причинения вреда другим? Предположим, цель Дейты — спасти своего товарища по команде, но он не может добраться до нее из-за повреждения одной из своих конечностей.

Снижение активности Дейты, которое мешает ему спасти своего товарища по команде, является своего рода нефеноменальным страданием. Он предпочел бы спасти члена экипажа, и было бы лучше, если бы он это сделал.

В эпизоде вопрос в конечном итоге упирается не в то, обладает ли Дейта самосознанием — это не вызывает сомнений. Не вызывает сомнений и то, разумен ли он — он легко доказывает, что он таков в общем смысле. Неясно, является ли он феноменально сознательным. Данные не демонтированы, потому что, в конце концов, его человеческие судьи не могут договориться о значении сознания для морального положения.

Должен ли ИИ получить моральную репутацию?

Дейта добрый — он действует, чтобы поддерживать благополучие своих товарищей по команде и тех, кого он встречает на чужих планетах. Он подчиняется приказам людей и, похоже, вряд ли причинит им вред, и, кажется, защищает свое собственное существование. По этим причинам он кажется миролюбивым, и его легче принять в мир вещей, имеющих моральное значение.

А как же Скайнет в фильмах «Терминатор»? Или опасения, недавно высказанные Илоном Маском о том, что ИИ опаснее ядерного оружия, и Стивеном Хокингом о том, что ИИ уничтожит человечество?

Люди не теряют своих притязаний на моральное положение только потому, что действуют против интересов другого человека. Точно так же вы не можете автоматически сказать, что только потому, что ИИ действует против интересов человечества или другого ИИ, он не имеет морального статуса.

Возможно, вы имеете право дать отпор такому ИИ, как Скайнет, но это не лишает его морального авторитета. Если моральный статус дается благодаря способности нефеноменально страдать, то Скайнет и Дейта оба получают его, даже если только Дейта хочет помочь людям.

Искусственных машин общего интеллекта пока нет. Но сейчас самое время подумать, что потребуется, чтобы обеспечить им моральное положение. То, как человечество решит ответить на вопрос о моральном статусе небиологических существ, будет иметь большое значение для того, как мы будем относиться к будущим ИИ — будь то добрые и полезные, как Дейта, или настроенные на разрушение, как Скайнет.

Ананд Вайдья, адъюнкт-профессор философии, Государственный университет Сан-Хосе.

Поделитесь в вашей соцсети👇