Искусственный интеллект: Доверие и недоверие в эру технологий

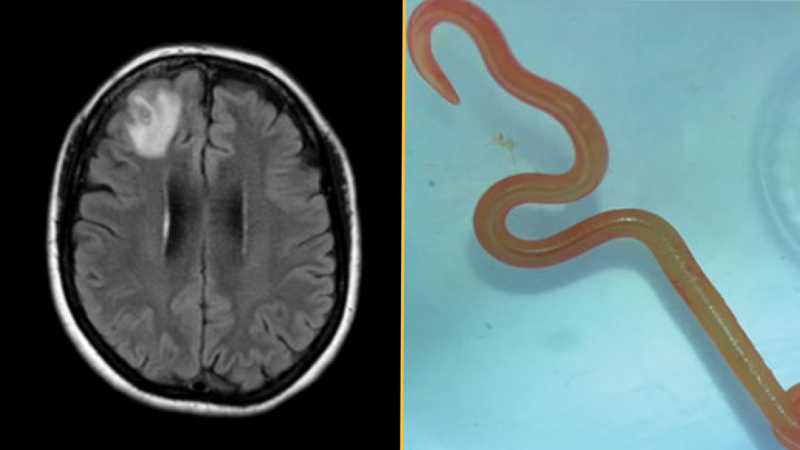

От создания электронных писем с помощью ChatGPT до рекомендательных систем и диагностики заболеваний — присутствие машинного интеллекта в повседневной жизни уже не является научной фантастикой.

Тем не менее, несмотря на все обещания быстроты, точности и оптимизации, остается некое беспокойство. Некоторые люди любят использовать инструменты ИИ. Другие испытывают тревогу, недоверие и даже предательство. В чем же дело?

Ответ кроется не только в том, как работает ИИ, но и в том, как мы функционируем. Мы не понимаем его полностью, и это вызывает недоверие. Люди, как правило, доверяют системам, которые легко понять. Традиционные инструменты кажутся привычными: повернули ключ — и машина завелась, нажали на кнопку — и лифт приехал.

Многие системы ИИ функционируют как черные ящики: вы вводите данные, и появляется решение, логика при этом остается скрытой. Психологически это вызывает дискомфорт, ведь нам нравятся причинно-следственные связи, и хочется иметь возможность изучать принимаемые решения. Когда такой возможности нет, появляется ощущение безысходности.

Это одна из причин, по которой возникает так называемая «избежание алгоритмов». Исследования показывают, что люди часто отдают предпочтение несовершенному человеческому суждению, чем алгоритмическому, особенно после того, как станут свидетелями даже одной ошибки ИИ.

Мы понимаем, что системы ИИ не имеют эмоций или скрытых намерений. Но это не мешает нам проецировать на них человеческие черты. Например, когда ChatGPT отвечает слишком вежливо, некоторым пользователям это кажется пугающим. Когда рекомендательная система оказывается слишком точной, возникает чувство вторжения. Мы начинаем подозревать манипуляцию, хотя системы не имеют никакого «я».

Новые вызовы для доверия

Интересный аспект поведенческой науки заключается в том, что мы часто более снисходительны к человеческим ошибкам, чем к ошибкам машин. Когда человек ошибается, мы можем понять и даже посочувствовать им. Но если алгоритм ошибается, особенно если его позиционируют как объективный или основанный на данных, мы чувствуем себя преданными.

Это связано с нарушением ожиданий: когда наши предположения о том, как что-то должно функционировать, оказываются нарушенными, это вызывает дискомфорт и утрату доверия. Мы доверяем машинам, полагая, что они логичны и беспристрастны. Поэтому, когда они не оправдывают этих ожиданий, например, неправильно классифицируют изображение, мы реагируем гораздо острее — мы ожидали большего.

Ирония заключается в том, что люди принимают ошибочные решения постоянно, но хотя бы могут спросить их «почему?».

Нужда в эмоциональных сигналах

Доверие человека основывается не только на логике. Мы считываем тон, мимику, колебания в голосе и зрительный контакт. У ИИ этого нет. Он может быть красноречивым и даже обаятельным, но не дает нам того спокойствия, которое может обеспечить другой человек.

Это похоже на дискомфорт, связанный с «долиной ужаса» — термином, придуманным японским робототехником Масахиро Мори для описания странного чувства, когда нечто практически человеческое, но не совсем. Оно выглядит или звучит правильно, но что-то чувствуется не так. Это эмоциональное отсутствие может восприниматься как холодность или даже обман.

В мире полной глубоких фейков и алгоритмических решений такое отсутствие эмоциональной резонансности становится проблемой. Не потому, что ИИ совершает ошибки, а потому что мы не знаем, как к этому относиться.

Важно отметить: не все сомнения в ИИ иррациональны. Алгоритмы действительно могут отражать и усилить предвзятости, особенно в таких сферах, как набор персонала, правопорядок и кредитное scoring. Если вы когда-либо сталкивались с ущербом или несправедливостью со стороны систем данных, вы не параноик, вы просто осторожны.

Доверие должно быть завоевано. Это требует разработки ИИ-инструментов, которые являются прозрачными и подотчетными. Если мы хотим, чтобы ИИ был принят, ему надо стать не черным ящиком, а собеседником, в диалоге с которым мы готовы участвовать.