Ложь в глаза: как даже «супер-распознаватели» проигрывают ИИ и что поможет разоблачить фейк

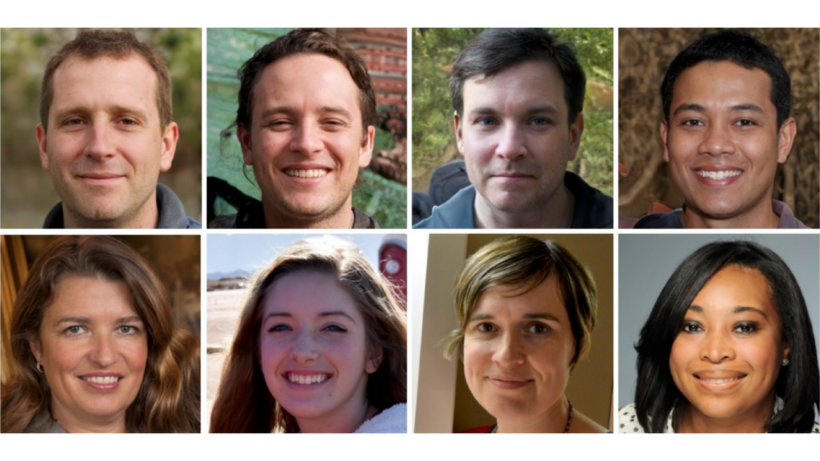

Изображения лиц, сгенерированные искусственным интеллектом (ИИ), настолько реалистичны, что даже «супер-распознаватели» — элитная группа людей с исключительными способностями к обработке черт лица — определяют подделку не лучше, чем простой случайный выбор.

Люди с обычными способностями к распознаванию лиц справляются даже хуже случайности: чаще всего они принимают сгенерированные ИИ лица за настоящие.

Таковы результаты исследования, опубликованного 12 ноября в журнале Royal Society Open Science. Однако та же работа показала, что даже пять минут обучения, посвящённого типичным ошибкам рендеринга в ИИ, значительно улучшают способность человека обнаруживать подделку.

«Я думаю, обнадёживает тот факт, что наша довольно короткая обучающая процедура значительно повысила результативность в обеих группах», — рассказала Live Science ведущий автор исследования Кэти Грей, доцент кафедры психологии Университета Рединга в Великобритании.

Удивительно, но обучение повысило точность распознавания у супер-распознавателей и обычных людей примерно в одинаковой степени, отметила Грей. Поскольку супер-распознаватели изначально лучше определяют фальшивые лица, это говорит о том, что они полагаются на какой-то иной набор подсказок, а не только на ошибки рендеринга.

Грей надеется, что в будущем учёные смогут использовать усиленные навыки обнаружения супер-распознавателей для более точного выявления изображений, созданных ИИ.

«Для наиболее эффективного обнаружения синтетических лиц, возможно, стоит использовать алгоритмы детекции ИИ в сочетании с подходом «человек в цикле» — где этим человеком является обученный супер-распознаватель», — написали авторы в исследовании.

Обнаружение дипфейков

В последние годы в сети наблюдается настоящий шквал изображений, сгенерированных ИИ. Лица-дипфейки создаются с помощью двухэтапного алгоритма ИИ под названием «генеративно-состязательные сети» (GAN). Сначала генерируется поддельное изображение на основе реальных фотографий, а затем получившееся изображение анализируется «дискриминатором», который определяет, настоящее оно или фальшивое. В процессе итераций фейковые изображения становятся настолько реалистичными, что обманывают дискриминатор.

Эти алгоритмы настолько усовершенствовались, что людей часто вводят в заблуждение, заставляя думать, будто фальшивые лица выглядят «натуральнее», чем настоящие — этот феномен известен как «гиперреализм».

В результате исследователи теперь пытаются разработать методики обучения, которые могли бы улучшить способности людей обнаруживать лица, созданные ИИ. Эти тренинги указывают на распространённые ошибки рендеринга в таких изображениях: например, «средний зуб» между передними резцами, странная линия роста волос или неестественная текстура кожи. Также подчёркивается, что фейковые лица, как правило, более пропорциональны, чем реальные.

В теории, так называемые супер-распознаватели должны справляться с обнаружением подделок лучше, чем обычный человек. Эти люди демонстрируют выдающиеся способности в задачах на восприятие и распознавание лиц — например, когда нужно определить, один и тот же человек или два разных изображены на двух фотографиях незнакомцев. Однако до сих пор мало исследований изучали способности супер-распознавателей выявлять поддельные лица и то, может ли обучение улучшить их результаты.

Чтобы восполнить этот пробел, Грей и её команда провели серию онлайн-экспериментов, сравнив показатели группы супер-распознавателей с обычными людьми. Супер-распознаватели были привлечены из волонтёрской базы лаборатории распознавания лиц и голоса Гринвичского университета; они показали результаты в топ-2% в задачах, где нужно было запомнить незнакомые лица.

В первом эксперименте на экране появлялось изображение лица — либо реальное, либо созданное компьютером. У участников было 10 секунд, чтобы решить, настоящее лицо или нет. Супер-распознаватели справились не лучше случайного угадывания, определив лишь 41% лиц, созданных ИИ. Обычные участники правильно идентифицировали только около 30% подделок.

Группы также различались по частоте, с которой они принимали настоящие лица за фейковые. Это произошло в 39% случаев у супер-распознавателей и примерно в 46% — у обычных участников.

Следующий эксперимент был идентичен первому, но в нём участвовала новая группа людей, прошедшая пятиминутный тренинг. Им показали примеры ошибок в лицах, сгенерированных ИИ. Затем их протестировали на 10 изображениях лиц, давая обратную связь в реальном времени о точности обнаружения подделок. Завершающим этапом обучения был повторный разбор ошибок рендеринга, на которые стоит обращать внимание. После этого участники повторили исходное задание из первого эксперимента.

Обучение значительно повысило точность обнаружения: супер-распознаватели определили 64% фейковых лиц, а обычные участники — 51%. Частота, с которой каждая группа ошибочно принимала реальные лица за поддельные, осталась примерно на том же уровне, что и в первом эксперименте: супер-распознаватели и обычные участники оценивали настоящие лица как «ненастоящие» в 37% и 49% случаев соответственно.

Обученные участники, как правило, тратили больше времени на изучение изображений, чем необученные: обычные участники замедлились примерно на 1,9 секунды, а супер-распознаватели — на 1,2 секунды. Грей отметила, что это ключевой посыл для любого, кто пытается определить, настоящее лицо перед ним или поддельное: не спешите и внимательно всматривайтесь в детали.

Однако стоит отметить, что тестирование проводилось сразу после завершения обучения, поэтому неясно, как долго сохраняется этот эффект.

«Эту тренировку нельзя считать устойчивым и эффективным вмешательством, поскольку повторное тестирование не проводилось», — написала в рецензии на исследование (до его публикации) Майке Рамон, профессор прикладной науки о данных и эксперт по обработке лиц в Бернском университете прикладных наук (Швейцария).

Поскольку в двух экспериментах участвовали разные люди, мы не можем быть уверены, насколько именно обучение улучшает навыки обнаружения у конкретного человека, добавила Рамон. Для этого потребовалось бы дважды протестировать одну и ту же группу людей — до и после обучения.

Гонка вооружений и будущее доверия

Полученные данные ярко иллюстрируют главную проблему цифровой эпохи: технологии создания поддельного контента развиваются быстрее, чем врождённые человеческие способности к их распознаванию. Даже уникальные навыки супер-распознавателей оказываются уязвимыми перед алгоритмами-генераторами. Это создаёт серьёзные риски — от мошенничества с идентификацией и создания компромата до подрыва доверия к визуальной информации в целом.

Будущее, вероятно, будет зависеть от симбиоза человека и машины. С одной стороны, необходимы простые и доступные тренинги для широкой публики, повышающие медиаграмотность и «гигиену восприятия». С другой — алгоритмы-детекторы должны стать стандартом для платформ и соцсетей. Но наиболее эффективной может стать гибридная модель, где окончательную проверку сомнительного контента осуществляют именно люди с исключительными перцептивными способностями, прошедшие специальную подготовку. Пока же главный совет исследователей остаётся простым: в мире, где нельзя верить своим глазам, самое важное — дать себе время на сомнение и внимательный анализ.