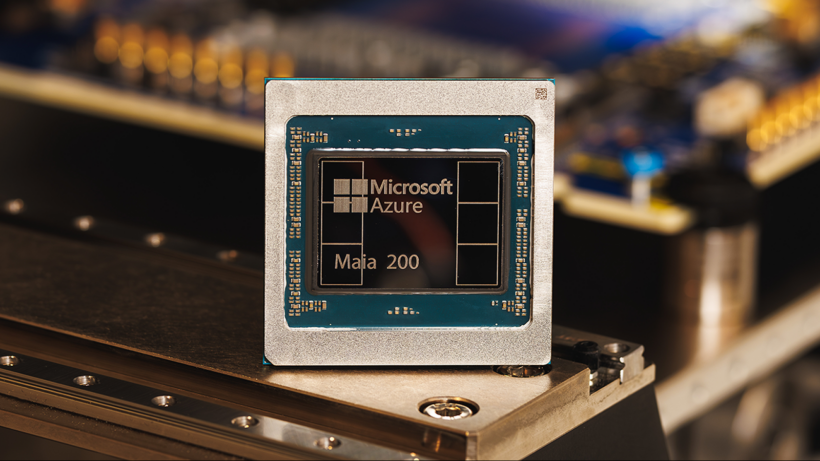

Новый чип Maia 200 от Microsoft: Революция в мире искусственного интеллекта

Microsoft представила новый ускоритель Maia 200 для искусственного интеллекта (ИИ), который по заявлению представителей компании в три раза мощнее оборудования конкурентов, таких как Google и Amazon. Этот чип будет использоваться для выполнения задач ИИ, а не для обучения, ускоряя процессы прогнозирования, предоставления ответов на запросы и генерации выходных данных на основе новых входных данных.

Уже в настоящее время Maia 200 развертывается в центральном дата-центре Microsoft в США, и компания планирует использовать эти чипы для генерации синтетических данных и усиленного обучения, чтобы улучшить модели больших языков (LLM) следующего поколения. Ускоритель ИИ также будет задействован в производственных процессах Microsoft Foundry и 365 Copilot, а также станет частью инфраструктуры, которую компания предоставляет через свою облачную платформу Azure.

Новый чип демонстрирует производительность более 10 петафлопс (10^15 операций с плавающей точкой в секунду), как отметил Скотт Гатри, исполнительный вице-президент по облачным технологиям и ИИ в Microsoft. Это показатель производительности в суперкомпьютерной технике, где самые мощные суперкомпьютеры в мире могут достигать более 1000 петафлопс.

Maia 200 достиг такого уровня производительности в категории представления данных, известной как «4-битное представление (FP4)», — тщательно сжатая модель, созданная для ускорения работы ИИ. Чип также показывает 5 PFLOPS в 8-битной точности (FP8). Разница между ними в том, что FP4 гораздо более энергоэффективен, но менее точен.

«В практических терминах, один узел Maia 200 может с легкостью обрабатывать крупнейшие модели современности, оставляя достаточно ресурсов для еще более крупных моделей в будущем,» — заявил Гатри в блоге. «Это означает, что Maia 200 предоставляет в три раза большую производительность FP4 по сравнению с третьим поколением Amazon Trainium и производительность FP8 выше, чем у седьмого поколения TPU от Google.»

Maia 200 также потенциально может быть использован для специализированных задач ИИ, таких как запуск больших LLM в будущем. На данный момент чипы Maia использовались исключительно в облачной инфраструктуре Azure для обработки крупных объемов данных для собственных сервисов ИИ Microsoft, в частности Copilot. Однако Гатри отметил, что в будущем «будет более широкий доступ для клиентов», что означает, что другие организации смогут получить доступ к Maia 200 через облако Azure или чипы могут быть задействованы в независимых дата-центрах или серверах.

Microsoft утверждает, что благодаря использованию 3-нм процессора компании TSMC, которая является «самой важной фабрикой в мире», удается достичь на 30% более высокой производительности на доллар по сравнению с существующими системами, что позволяет разместить до 100 миллиардов транзисторов на одном чипе. Это значит, что Maia 200 может оказаться более экономически эффективным и эффективным для самых требовательных задач ИИ, чем существующие чипы.

Maia 200 также предлагает много других функций, включая систему памяти, которая может помочь сохранить веса и данные модели ИИ локально, что снижает потребность в hardware для запуска модели. Кроме того, он разработан для быстрой интеграции в существующие дата-центры.

Maia 200 должен обеспечить более быструю и эффективную работу моделей ИИ, что означает, что пользователи Azure OpenAI, такие как ученые, разработчики и корпорации, могут ожидать более высокую пропускную способность и скорость при разработке приложений ИИ и использовании, например, GPT-4 в своих операциях.

Хотя этот следующий этап в аппаратном обеспечении ИИ вряд ли окажет значительное влияние на повседневное использование ИИ и чат-ботов на коротком временном отрезке — ведь Maia 200 предназначен для дата-центров, а не для потребительского оборудования — конечные пользователи могут ощутить его влияние в виде более быстрых ответов и потенциально более продвинутых функций в таких инструментах, как Copilot и других ИИ-инструментах, встроенных в Windows и продукты Microsoft.

Maia 200 также может предоставить прирост производительности разработчикам и ученым, использующим ИИ-инференс через платформы Microsoft. Это, в свою очередь, может привести к улучшениям в развертывании ИИ в рамках крупномасштабных научных проектов, таких как продвинутое моделирование погоды, биологических или химических систем и составов.