Опасный эксперимент: Как замена соли по совету ChatGPT привела мужчину в больницу с галлюцинациями

Шестидесятилетний мужчина, решивший изменить свой рацион с помощью ChatGPT, через три месяца оказался в отделении неотложной помощи с острыми психиатрическими симптомами: паранойей и галлюцинациями. Как выяснилось, причиной его состояния стал бромизм — синдром, вызванный хроническим отравлением соединениями брома. Об этом случае сообщили 5 августа в журнале Annals of Internal Medicine Clinical Cases.

Химическая ловушка

Пациент, обеспокоенный потенциальным вредом поваренной соли (хлорида натрия), решил заменить её на бромид натрия, купленный в интернете. Вдохновившись советами ChatGPT, он полностью исключил хлорид из рациона. Однако искусственный интеллект не предупредил его, что бромид натрия токсичен для человека при длительном употреблении.

В XIX–XX веках соединения брома широко использовались в медицине как успокоительные и противосудорожные средства. Но из-за накопления в организме они вызывали бромизм — состояние, сопровождающееся психозами, нарушением координации и памяти. После запрета бромидов в безрецептурных препаратах в 1980-х случаи отравления стали редкостью, но сегодня они вновь появляются из-за доступности опасных добавок в сети.

Ложный совет и его последствия

Мужчина, по собственным словам, изучал нутрициологию в университете и решил провести «личный эксперимент». Он спросил у ChatGPT, чем заменить хлорид, и получил ответ: «бромидом натрия». Врачи, позже воспроизведя запрос в ChatGPT 3.5, подтвердили, что система действительно предлагала этот вариант, хотя и с оговоркой о контексте. Однако критической информации о токсичности для ИИ не хватило.

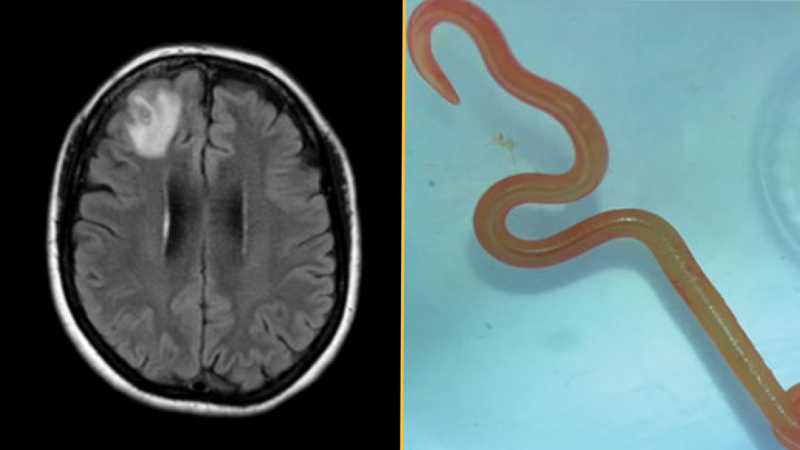

Через три месяца у пациента появились симптомы отравления: паранойя, бессонница, акне и нарушение координации. В больнице анализы выявили псевдогиперхлоремию — ложное повышение хлоридов из-за брома в крови. Мужчине потребовалась госпитализация, введение антипсихотиков и восстановление электролитного баланса.

Уроки для будущего

Авторы отчёта подчеркивают: несмотря на потенциал ИИ в популяризации знаний, его информация часто лишена контекста. «Медик никогда не посоветовал бы замену соли на токсичный аналог», — отмечают врачи. В OpenAI напомнили, что их сервисы не заменяют профессиональную консультацию, а команды безопасности работают над минимизацией рисков.

Этот случай — не единственный тревожный сигнал. Недавние исследования показали, что языковые модели склонны к «галлюцинациям» в медицинских вопросах, даже после корректировок. Эксперты призывают относиться к советам ИИ критически и всегда проверять их у специалистов.

Важно: Материал носит информационный характер и не заменяет консультацию врача или диетолога. При изменениях в рационе или лечении обратитесь к профессионалам.